La optimización de motores de búsqueda (SEO) es un campo en constante evolución. Para los propietarios de negocios y los buscadores de servicios de marketing, mantenerse al día con las últimas tendencias y técnicas puede ser un desafío.

Una de las herramientas más subestimadas en el arsenal de SEO es el archivo robots.txt. Este pequeño pero poderoso archivo puede tener un impacto significativo en cómo los motores de búsqueda interactúan con su sitio web.

Pero, ¿qué es exactamente robots.txt? Es un archivo de texto simple que los webmasters utilizan para dar instrucciones a los motores de búsqueda sobre qué páginas de su sitio deben ser rastreadas e indexadas.

Aunque puede parecer técnico, entender y utilizar correctamente robots.txt es crucial para el éxito de su SEO. Un archivo robots.txt mal configurado puede llevar a los motores de búsqueda a ignorar páginas importantes de su sitio, afectando su visibilidad en línea.

En este artículo, exploraremos en profundidad la importancia de robots.txt en SEO. Cubriremos desde su definición y función, hasta cómo crear y mantener un archivo robots.txt efectivo.

Además, discutiremos los errores comunes a evitar y proporcionaremos consejos prácticos para integrar la gestión de robots.txt en su estrategia de SEO.

Así que, si está buscando mejorar su SEO y aumentar la visibilidad de su sitio web, siga leyendo. Este artículo es para usted.

Tabla de Contenidos

¿Qué es robots.txt y por qué es crucial para tu SEO?

El archivo robots txt es un componente esencial del SEO técnico. Su función principal es comunicar a los motores de búsqueda qué partes de su sitio web pueden rastrear. Esto es esencial para optimizar el presupuesto de rastreo, asegurando que se concentre en las páginas más valiosas.

Al igual que un portero que dirige el tráfico, robots.txt guía a los rastreadores sobre dónde pueden y no pueden ir. Con instrucciones simples, establece límites y prioridades que los motores de búsqueda deben seguir al indexar su sitio.

¿Por qué es tan importante? Un archivo robots.txt bien configurado garantiza que solo las páginas relevantes sean indexadas. Esto puede afectar significativamente la visibilidad de su sitio en los resultados de búsqueda, aumentando su relevancia y autoridad.

Las principales directivas en este archivo son Allow y Disallow. Estas indican a los motores de búsqueda qué URL deben o no ser rastreadas. Sin estas directivas, los motores de búsqueda podrían desperdiciar tiempo y recursos, indexando contenido irrelevante.

La configuración incorrecta de robots.txt puede tener graves consecuencias. Las páginas importantes podrían no ser indexadas, o peor aún, información sensible podría quedar expuesta. Por esto, es vital entender su configuración adecuada.

Para asegurar que su archivo robots.txt esté optimizado para el SEO, tenga en cuenta los siguientes consejos:

- Utilice directivas claras: Evite la ambigüedad en las instrucciones.

- Revise regularmente el archivo: Asegúrese de que esté actualizado con la estructura actual de su sitio.

- Evite errores comunes: Verifique que las URL especificadas sean correctas.

En resumen, un archivo robots.txt bien configurado es fundamental para el éxito de su SEO. Administra el acceso de los motores de búsqueda, mejora la eficiencia del rastreo y, en última instancia, maximiza la visibilidad de su sitio web. Con cuidado y atención, puede ser una herramienta poderosa en su estrategia de marketing digital.

Cómo los motores de búsqueda interactúan

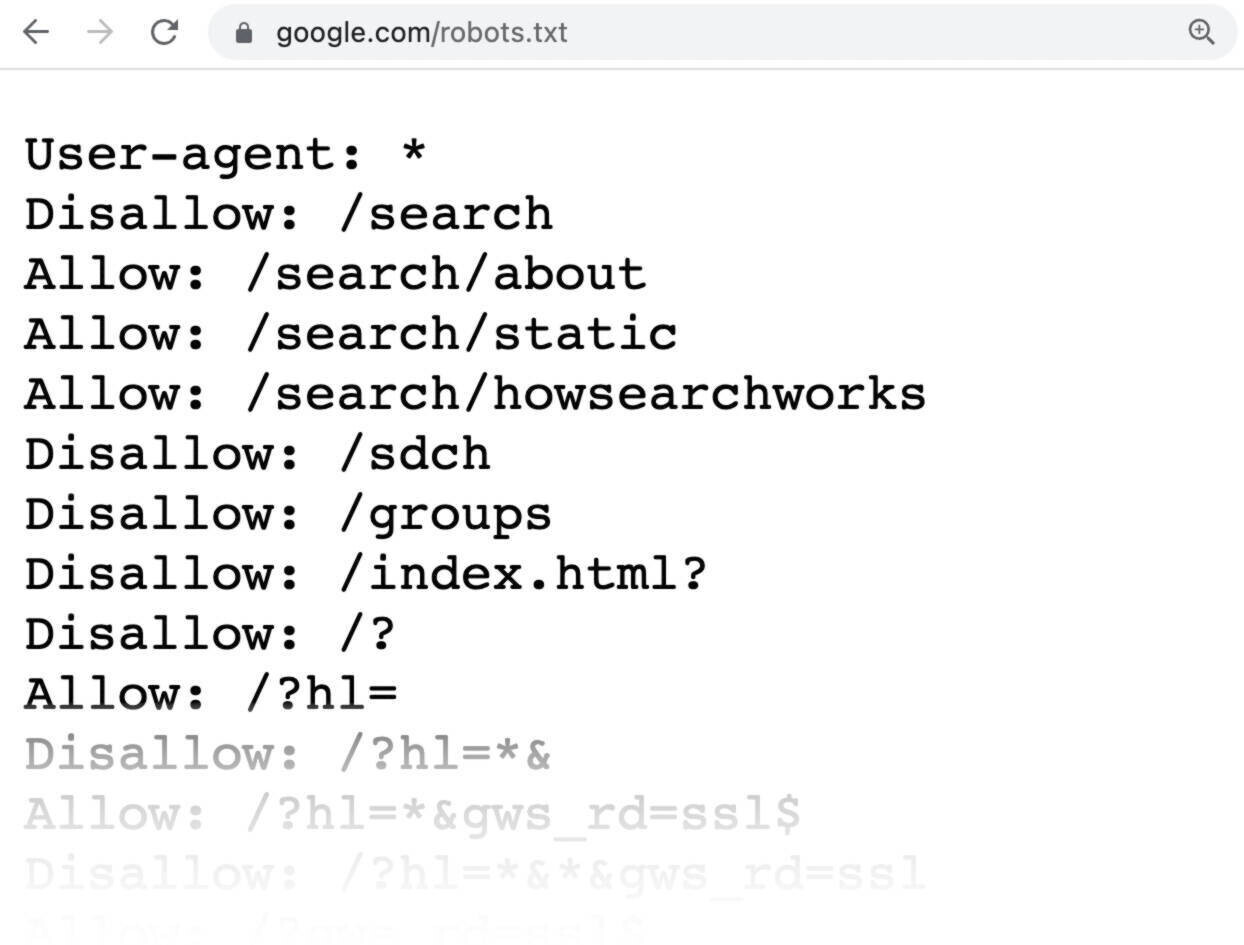

Cuando un motor de búsqueda visita su sitio web, lo primero que hace es buscar el archivo robots.txt. Este archivo, ubicado en el directorio raíz de su sitio, establece las reglas de rastreo que el motor debe seguir. Actúa como un mapa que define qué contenido está disponible para rastrear e indexar.

Los motores de búsqueda como Google, Bing y otros, respetan las directivas de robots.txt. Sin embargo, cabe destacar que no todos los bots obedecen estas reglas. Por lo tanto, aunque robots.txt es una herramienta poderosa, no debe usarse para proteger información confidencial.

Cada vez que un bot llega a su sitio, consulta el archivo robots.txt para determinar qué partes puede explorar. Si las directrices son claras, el bot sigue su camino, concentrándose en las áreas permitidas para el rastreo y ahorrando tiempo valioso tanto para el motor como para el servidor del sitio.

La eficiencia del rastreo es crucial. Los motores de búsqueda tienen un presupuesto de rastreo limitado para cada sitio. Un archivo robots.txt optimizado asegura que este presupuesto se utilice de manera eficiente, maximizando la posibilidad de que las páginas importantes sean indexadas.

Los errores en el archivo robots.txt, como directivas contradictorias o mal configuradas, pueden confundir a los motores de búsqueda. Esto puede resultar en la no indexación de contenido clave o, peor aún, en la indexación no deseada de datos sensibles. Por eso, mantener un archivo robots.txt bien estructurado es vital para la salud de su SEO.

Creación de un archivo robots.txt efectivo

Crear un archivo robots.txt efectivo es vital para guiar a los motores de búsqueda. Este archivo define qué partes de su sitio web deben ser rastreadas e indexadas. Al hacerlo correctamente, permite controlar la exposición de su contenido en los resultados de búsqueda.

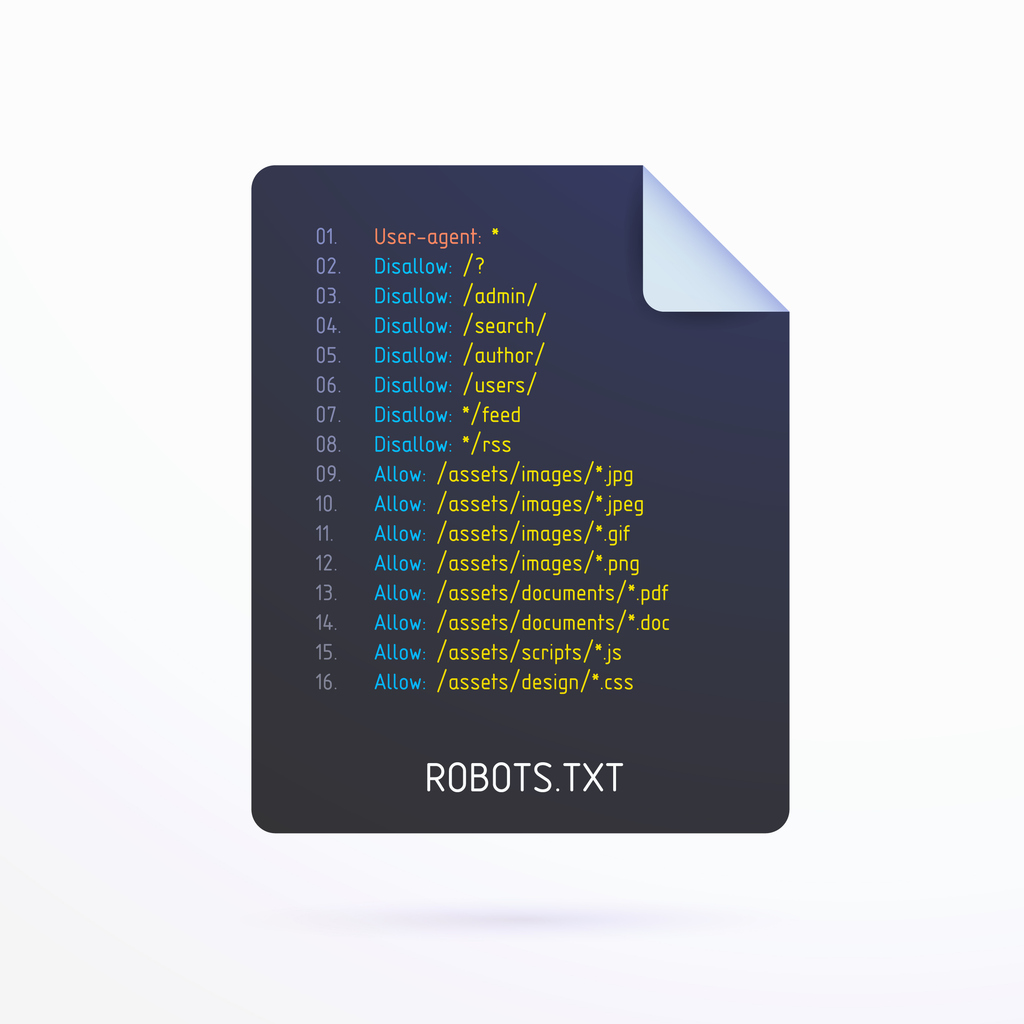

Primero, es fundamental entender las directivas básicas: Disallow, Allow y Sitemap. La directiva Disallow impide que los bots rastreen ciertas áreas del sitio. Por otro lado, Allow es específico para páginas que desea que se rastreen, incluso si están en directorios Disallow.

El archivo robots.txt debe ubicarse en el directorio raíz de su dominio. Esto permite a los motores de búsqueda encontrarlo rápidamente. Mantenerlo ordenado es crucial para evitar errores de rastreo que podrían costarle visibilidad en línea.

Una técnica recomendada es listar primero las URL que desee Disallow. Esto asegura que no sean rastreadas accidentalmente antes de que se lean las directivas posteriores. También, es esencial mantener una documentación clara dentro del archivo sobre los cambios realizados y el propósito de las directivas.

Aquí hay una lista de pasos para crear un archivo robots.txt efectivo:

- Determine qué contenido debe ser indexado o excluido.

- Use un editor de texto para crear un archivo robots.txt.

- Liste las directivas en un orden lógico y claro.

- Pruebe el archivo con herramientas de validación.

- Cargue el archivo en el directorio raíz de su sitio web.

Por último, revise su archivo regularmente y ajústelo según los cambios en su contenido o estructura del sitio. Esto asegurará que su estrategia SEO esté siempre alineada con sus objetivos comerciales.

Herramientas y recursos para generar y validar archivos robots.txt

Existen diversas herramientas que facilitan la creación y validación de archivos robots.txt. Estas herramientas pueden ahorrar tiempo y asegurar que su archivo no contenga errores que afecten el SEO de su sitio.

Google Search Console es una herramienta indispensable. Permite probar cómo los bots de Google interpretarían su archivo robots.txt, ayudándole a identificar problemas antes de que afecten la visibilidad.

Otra opción es Robots.txt Generator, una herramienta en línea que asiste en la creación de un archivo robots.txt básico. Con ella, puede seleccionar qué secciones de su sitio debe el bot ignorar.

Aquí una lista de recursos útiles para gestionar su archivo robots.txt:

- Google Search Console: Para probar y depurar su archivo.

- Robots.txt Generator: Generador en línea para crear archivos rápidamente.

- SEO Analyzer Tools: Para auditar y optimizar el rendimiento SEO de su sitio.

Utilizar estas herramientas garantizará que su archivo robots.txt esté bien configurado, maximizando su eficacia y minimizando el riesgo de errores.

Directivas comunes en robots.txt y su propósito

El archivo robots.txt utiliza varias directivas para guiar el comportamiento de los rastreadores web. Comprender estas directivas es crucial para gestionar eficazmente el acceso de los motores de búsqueda a su sitio.

Una de las directivas más fundamentales es User-agent. Esta directiva específica permite dirigir instrucciones a ciertos bots, posibilitando un control más granular sobre quién puede acceder a su contenido.

La directiva Disallow es otra herramienta esencial. Prohíbe a los bots acceder a ciertas áreas de su sitio que no quiere indexar, como páginas de administración o directorios privados. Esto es especialmente útil para evitar que contenido sensible o irrelevante aparezca en los resultados de búsqueda.

El comando Allow, por otro lado, garantiza que los bots rastreen ciertas páginas dentro de un directorio previamente bloqueado. Esto es útil para casos donde quiere permitir el acceso a páginas específicas muy relevantes dentro de una carpeta restringida.

Otro recurso importante es la directiva Sitemap. Incluir el enlace a su archivo sitemap.xml en robots.txt proporciona a los motores de búsqueda un camino claro para acceder al contenido que desea que indexen.

Aquí hay un resumen de las directivas comunes y su propósito:

- User-agent: Dirige instrucciones específicas a distintos rastreadores.

- Disallow: Previene el rastreo de partes no deseadas del sitio.

- Allow: Permite el rastreo de páginas específicas dentro de áreas restringidas.

- Sitemap: Proporciona la ubicación del sitemap para facilitar la indexación.

Además, para sitios más grandes, el uso inteligente de la directiva Crawl-delay puede optimizar el uso de recursos del servidor, reduciendo la carga durante el rastreo. La correcta aplicación de estas directivas mejora la eficiencia del sitio y su rendimiento SEO.

Disallow vs Allow: Cómo y cuándo usarlos

Utilizar Disallow y Allow adecuadamente es crucial para controlar el acceso de los bots a su contenido. Disallow es ideal para mantener fuera de los motores de búsqueda contenido sensible o que no tiene valor SEO, como páginas de inicio de sesión.

Mientras tanto, Allow es especialmente útil cuando necesita excepciones dentro de directorios bloqueados por Disallow. Por ejemplo, puede restringir un directorio completo, pero aún permitir el acceso a una página clave dentro de él.

Es esencial evaluar regularmente su contenido para decidir qué partes necesitan restricciones. Las decisiones estratégicas sobre cuándo usar Disallow o Allow deben basarse en la relevancia del contenido para sus objetivos de SEO y la experiencia del usuario.

La importancia de la directiva Sitemap en robots.txt

Incluir la directiva Sitemap en el archivo robots.txt es una práctica que puede mejorar significativamente la eficiencia de la indexación. Al proporcionar la URL de su sitemap.xml, facilita a los motores de búsqueda la tarea de encontrar y rastrear el contenido relevante de su sitio.

La inserción de Sitemap también ayuda a destacar la estructura de su sitio web, permitiendo una indexación más eficiente. Esto es esencial para sitios grandes, donde el contenido puede estar distribuido en múltiples directorios y ser fácilmente pasado por alto.

Un sitemap bien organizado y vinculado correctamente asegura que las páginas importantes sean descubiertas e indexadas rápidamente. Esto resulta en una mejor exposición en los resultados de búsqueda y, en última instancia, puede conducir a un aumento del tráfico orgánico.

Asegúrese de mantener actualizado su sitemap para reflejar cambios en el contenido y nuevas adiciones al sitio. Esta directiva sirve como una guía precisa de lo que realmente debería ser indexado, reforzando la relevancia de su presencia en línea.

Errores comunes en robots.txt y cómo evitarlos

Configurar un archivo robots.txt incorrectamente puede resultar en problemas significativos para su SEO. Uno de los errores más comunes es bloquear accidentalmente páginas que deberían ser accesibles a los motores de búsqueda. Esto puede ocurrir cuando se usa la directiva Disallow en niveles demasiado amplios, restringiendo páginas valiosas.

Otro error común es no actualizar el archivo robots.txt después de cambios significativos en el sitio web. Cualquier reestructuración, como mover contenido o cambiar la estructura de URL, debería reflejarse en una revisión del archivo robots.txt para asegurar que las nuevas páginas sean rastreadas correctamente.

La falta de especificidad en las directivas es también problemática. Emplear directivas demasiado genéricas puede llevar a una falta de control sobre qué páginas son accesibles. Es vital utilizar rutas precisas para cada directiva para evitar consecuencias indeseadas.

El no incluir la directiva Sitemap es otra oportunidad perdida. Aunque puede parecer un paso trivial, omitir la URL de su sitemap.xml puede evitar que los motores de búsqueda alcancen todo su contenido de manera óptima.

Para asegurar que su archivo robots.txt esté configurado correctamente, considere estas prácticas:

- Revise regularmente el archivo: especialmente después de cambios importantes en el sitio.

- Use herramientas de validación: para verificar que las directivas se interpretan como se espera.

- Sea específico: con sus rutas y directivas para evitar confusiones innecesarias.

- Incluya siempre su sitemap.xml: para una indexación más eficiente.

Al evitar estos errores comunes, optimizará la interacción de su sitio web con los motores de búsqueda, mejorando su visibilidad y eficiencia general.

El impacto de robots.txt en la visibilidad y el rendimiento del sitio web

La correcta configuración del archivo robots.txt es crucial para mejorar la visibilidad de un sitio web en los motores de búsqueda. Este archivo ayuda a definir qué partes de un sitio deben ser accesibles para los motores de búsqueda, optimizando el rastreo y la indexación.

Un archivo robots.txt bien configurado puede dirigir el tráfico de los motores de búsqueda a las páginas más importantes. Esto garantiza que el contenido relevante esté siempre visible, potenciando así el rendimiento del sitio en las SERPs (páginas de resultados de los motores de búsqueda).

Sin un archivo robots.txt o con configuraciones incorrectas, es posible que se rastreen páginas menos importantes o incluso irrelevantes. Esto no solo desperdicia el presupuesto de rastreo del sitio, sino que también puede llevar a la indexación de contenido que no aporta valor.

Además, una correcta gestión del archivo robots.txt puede ayudar a reducir la carga del servidor. Al controlar el acceso del robot a ciertas partes del sitio, se mejora el rendimiento del mismo, lo que se traduce en una mejor experiencia para el usuario.

Casos prácticos de éxito y fracaso en el uso de robots.txt

Un ejemplo de éxito es un sitio de comercio electrónico que optimizó su archivo robots.txt para bloquear páginas de categorías y etiquetas duplicadas. Esta estrategia concentró el rastreo en páginas de productos individuales, resultando en un aumento significativo del tráfico orgánico y una mejora en las posiciones de búsqueda.

Por otro lado, un caso de fracaso incluyó a un blog que accidentalmente bloqueó toda su sección de artículos a través de su archivo robots.txt. Este error pasó desapercibido durante meses, causando una drástica caída en el tráfico y la pérdida de posiciones en resultados de búsqueda.

Otro caso exitoso muestra a una empresa que utilizó el archivo robots.txt para apuntar a su sitemap.xml. Esto mejoró rápidamente la detección de nuevo contenido por parte de los motores de búsqueda, manteniendo su contenido siempre actualizado en los resultados.

Por el contrario, una tienda en línea cometió el error de permitir el acceso a páginas de pago en pruebas. No solo causó problemas con la indexación de contenido irrelevante, sino que también levantó alertas de seguridad. Estos ejemplos subrayan la importancia de manejar diligentemente el archivo robots.txt para evitar contratiempos y potencializar los beneficios de SEO.

Integración de la gestión de robots.txt en tu estrategia SEO

Incorporar robots.txt en la estrategia SEO es esencial para optimizar la visibilidad en línea. Un enfoque integral incluye la alineación de directivas de rastreo con los objetivos de marketing. Esto asegura que las páginas correctas sean accesibles y bien representadas en los motores de búsqueda.

La gestión de robots.txt debe ser dinámica, adaptándose a cambios en el contenido y estructura del sitio web. Revisiones regulares del archivo ayudan a mantener su eficacia, optimizando el rendimiento de la estrategia SEO de manera continua.

Una comprensión adecuada de cómo interactúan los motores de búsqueda con robots.txt permite ajustar la configuración para maximizar la indexación útil. Al integrar robots.txt de forma estratégica, puedes evitar problemas como el rastreo excesivo o la pérdida de prioridades.

Considera la herramienta robots.txt como parte de un enfoque global de SEO. De esta manera, se garantiza que los esfuerzos de optimización sean efectivos y que la visibilidad online mejore progresivamente. Además, la optimización del archivo robots.txt puede contribuir a una mejor gestión del presupuesto de rastreo.

Colaboración entre desarrolladores y especialistas en SEO

La colaboración entre desarrolladores y especialistas en SEO es crucial para la gestión efectiva de robots.txt. Los desarrolladores aportan conocimientos técnicos que son vitales para implementar directivas precisas y seguras.

Por otro lado, los especialistas en SEO aportan su comprensión del comportamiento de los motores de búsqueda y sus algoritmos. Esta colaboración asegura que las directivas en el archivo no solo sean técnicamente correctas, sino también estratégicamente beneficiosas.

Fomentar la comunicación constante entre ambos equipos facilita la identificación y rectificación de errores antes de que impacten negativamente el SEO. Un enfoque colaborativo en la gestión de robots.txt no solo optimiza la indexación, sino que también mejora la seguridad y el rendimiento general del sitio web. Al trabajar juntos, ambos equipos pueden lograr resultados que superen las expectativas iniciales de SEO.

Mantenimiento y actualización de tu archivo robots.txt

El mantenimiento regular de tu archivo robots.txt es crucial para asegurar su eficacia y relevancia. Con cada cambio en la estructura de tu sitio web, es recomendable revisar el archivo para reflejar estos ajustes. Esto ayuda a evitar errores de rastreo que podrían perjudicar tu SEO.

Una práctica efectiva es programar revisiones periódicas del archivo robots.txt. Durante estas revisiones, verifica que las directivas sean precisas y estén alineadas con los objetivos actuales de SEO. La obsolescencia en las directivas puede llevar a la pérdida de oportunidades de indexación y visibilidad en los motores de búsqueda.

Además, estar al tanto de las actualizaciones en los algoritmos de búsqueda puede influir en cómo configuras tu robots.txt. Los cambios en las prioridades de los motores de búsqueda pueden requerir ajustes en las directivas para mantener o mejorar el rendimiento del sitio. Así, un archivo robots.txt actualizado y bien mantenido se convierte en un valioso aliado en el éxito continuo de tu estrategia SEO.

Conclusión: La importancia de la educación continua en SEO y robots.txt

El mundo del SEO está en constante evolución y con él, la gestión del archivo robots.txt. Mantenerse actualizado en las mejores prácticas es esencial para maximizar la visibilidad en línea. La educación continua empodera a los propietarios de negocios con el conocimiento necesario para adaptar sus estrategias a los cambios del algoritmo de búsqueda.

Entender cómo y cuándo ajustar el archivo robots.txt puede ser un diferenciador clave en la competitividad online. A medida que las tecnologías evolucionan, los especialistas en marketing deben ser proactivos. Esto garantiza que su estrategia de robots.txt siga siendo eficiente y alineada con los objetivos comerciales.

Al invertir en la educación y comprensión del SEO y herramientas como el archivo robots.txt, las empresas se preparan mejor para el éxito a largo plazo. Este conocimiento profundo permite decisiones informadas que pueden impulsar una presencia en línea sólida y efectiva.